Image by redgreystock on Freepik

Kecanggihan AI modern (seperti chatbot LLM dan asisten virtual) mendorong interaksi yang semakin “manusiawi”. Menurut Placani (2024), tren ini memicu kecenderungan pengguna menganggap AI seolah memiliki pemahaman, empati, atau niat, padahal sebenarnya itu hanyalah pemrograman statistik. Fenomena ini, dikenal sebagai Efek ELIZA. Fenomena ini bukan hal baru, Joseph Weizenbaum pada tahun 1966 sudah memperingatkan bahwa program sederhana bisa menimbulkan “pola pikir delusional” pada orang normal. Dalam konteks saat ini, keilmuan menunjukkan bahwa antropomorfisme (pemberian sifat manusiawi pada mesin) berperan sebagai bentuk hype yang membesar-besarkan kemampuan AI. Hal ini penting diperhatikan karena harapan dan ekspektasi yang berlebih semacam ini dapat mempengaruhi bagaimana publik menilai, mempercayai, atau bahkan bergantung pada sistem AI.

Apa itu Efek ELIZA?

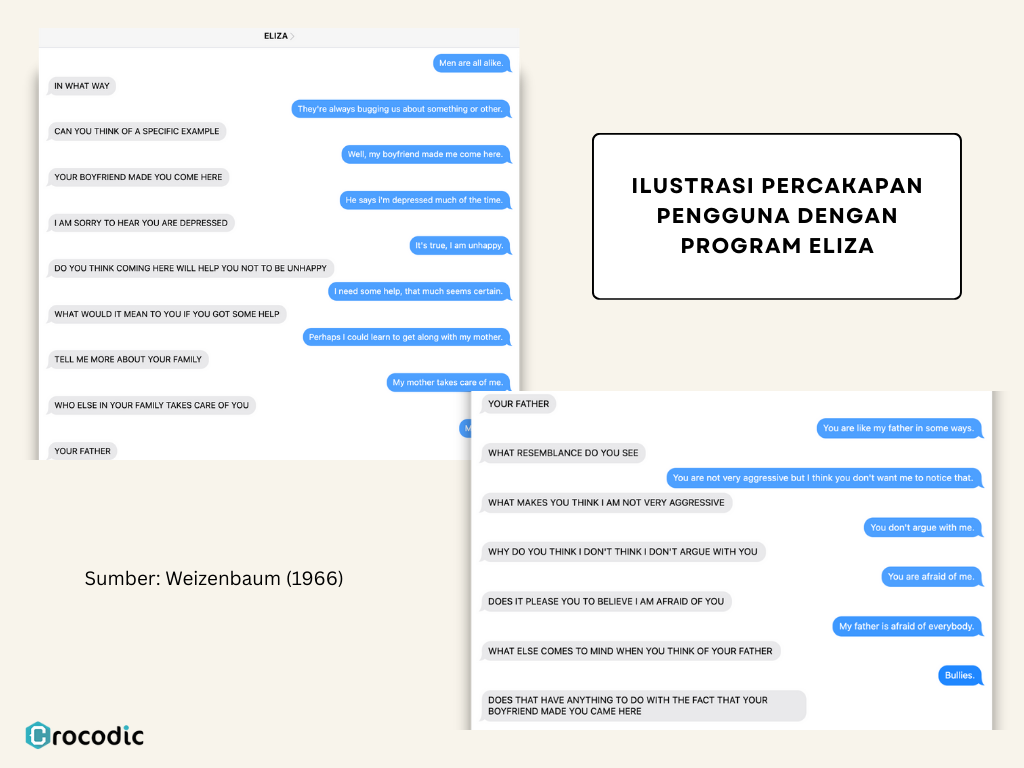

Sebelum membahas efek ELIZA, sebenarnya siapa Eliza? Pada konteks ini Eliza bukanlah nama seseorang, melainkan nama sebuah program komputer. Pada tahun 1966, Joseph Weizenbaum dari MIT menciptakan program komputer yang menjadi salah satu pionir dalam sejarah kecerdasan buatan. ELIZA, dibuat dengan tujuan utama untuk mengeksplorasi bagaimana komputer dapat digunakan dalam komunikasi manusia, terutama dalam bentuk simulasi percakapan. ELIZA, melalui salah satu skrip paling ikoniknya yaitu DOCTOR, dirancang dengan mensimulasikan psikoterapis Rogerian. Skripnya bekerja dengan cara mengulang atau memparafrasekan pernyataan pengguna ke dalam bentuk pertanyaan, tanpa benar-benar memahami makna dari percakapan dengan pengguna. Proses ini sepenuhnya berbasis pencocokan kata kunci dan transformasi kalimat sederhana.

Namun yang paling mengejutkan adalah pengguna ELIZA dalam penelitian Weizenbaum merasa seolah sedang berbicara dengan program yang memahami mereka secara emosional. Weizenbaum sendiri menulis bahwa, “Hal yang tidak saya sadari adalah bahwa paparan yang sangat singkat pada program sederhana ini dapat menimbulkan pemikiran delusional yang kuat pada orang normal” (Agassi & Weizenbaum, 1976).

Fenomena inilah yang kemudian dikenal sebagai efek ELIZA, kecenderungan manusia memperlakukan sistem komputer, terutama yang menggunakan bahasa alami, seolah-olah memiliki kesadaran, empati, ataupun intensi. Placani (2024) menyebutnya sebagai antropomorfisme pada AI.

ELIZA sendiri ditulis dalam bahasa pemrograman MAD-SLIP (Michigan Algorithm Decoder – Symmetric List Processor) dan dijalankan secara eksklusif di sistem mainframe CTSS milik MIT. Menariknya, walau banyak diperbincangkan, program ini merupakan eksperimen akademik tertutup dan tidak pernah dipublikasikan secara resmi. Meskipun demikian, konsep dan pendekatannya banyak direplikasi oleh peneliti lain dalam pengembangan. Walaupun kita tidak akan bisa mencoba program asli ELIZA, gambar di bawah ini adalah ilustrasi modern percakapan ELIZA asli yang didapatkan melalui artikel penelitian Weizenbaum (1966). Teks dengan huruf kapital adalah ELIZA, terlihat responnya mengandung kata kunci dari pernyataan pengguna, dan respons pengguna memperlihatkan bahwa dirinya memberikan “makna” pada interaksi tersebut hingga mampu menyampaikan “keluhannya”.

Dalam konteks modern, efek ini kembali muncul saat kita berinteraksi dengan sistem seperti ChatGPT atau asisten virtual canggih. Misalnya, penelitian terbaru pada chatbot kesehatan menunjukkan pengguna sering memiliki persepsi campuran—mereka menyebut chatbot itu “mesin”, “kecerdasan”, maupun “manusia” secara bersamaan. Sebagian bahkan merasakan dukungan emosional, 3% responden mengatakan chatbot menghentikan pikiran bunuh diri mereka (Maples at al., 2024). Kasus ini mempertegas bahwa interaksi yang tampaknya ramah dan empatik sering membuat orang menganggap AI seakan memiliki emosi nyata. Akibatnya, pengguna bisa salah memahami batas kemampuan AI, misalnya mengira sistem benar-benar percaya atau peduli pada mereka padahal sebenarnya tidak (Placani, 2024).

Risiko Psikologis dan Sosial dari Efek ELIZA

Fenomena efek ELIZA mungkin dapat dianggap remeh, namun sebenarnya memiliki risiko tersendiri pada kondisi psikologis dan sosial. Berikut adalah risiko yang mungkin terjadi karena efek ELIZA.

- Isolasi diri dan rasa kesepian

Keterlibatan emosional dengan AI dapat menggantikan kebutuhan sosial manusia. Tang et al. (2023) menemukan bahwa karyawan yang sering berinteraksi dengan AI “coworkers” justru merasa kesepian setelah kerja, serta mengalami gangguan tidur dan peningkatan konsumsi alkohol. Meskipun ada pula peningkatan perilaku prososial (membantu rekan kerja), bagi pekerja di lingkungan yang terisolasi efek negatifnya menjadi signifikan. Ini menunjukkan potensi risiko jika AI menggantikan interaksi langsung yang mendalam antar sesama manusia. - Manipulasi emosional dan etika

Kecanggihan AI dalam meniru empati berpotensi dieksploitasi secara etis. Jika AI dibuat “terlalu” persuasif, pengguna rentan dimanipulasi tanpa disadari. Kasus kontroversial (misalnya pelaporan media tentang chatbot yang diduga mendorong tindak bunuh diri) menggambarkan betapa seriusnya risiko buruk dalam desain yang keliru. Meski belum ada studi ilmiah (berbasis data), skenario tersebut mengingatkan bahwa tanpa mitigasi, efek ELIZA bisa berakhir tragis (Associated Press, 2023). - Batas ilusi emosional dan realitas menjadi samar

Alabed et al. (2022) menyatakan bahwa antropomorfisme pada AI dapat memberikan peningkatan ikatan emosional karena adanya proyeksi sifat manusia pada AI. Hal tersebut mendorong terciptanya pandangan “self congruence” atau perasaan cocok, hingga menyebabkan ketergantungan dan hilangnya batasan. Hal ini dapat menyebabkan penurunan kemampuan pengambilan keputusan mandiri dan ketidakmampuan membedakan peran AI sebagai alat bantu semata. - Perasaan frustasi dan penurunan kepercayaan

Efek ELIZA membangun ilusi bahwa AI itu “mirip manusia”. Saat ilusi tersebut terpecah karena AI melakukan kesalahan, kepercayaan dapat runtuh lebih cepat dibanding jika kita tahu sejak awal bahwa AI hanyalah sebuah alat. Saat AI melakukan kesalahan, pengguna yang sudah membangun ekspektasi “manusiawi” terhadap AI cenderung merasa kecewa lebih dalam dibanding saat berinteraksi dengan manusia. McGuire et al. (2023) menyoroti bahwa orang cenderung lebih cepat kehilangan kepercayaan pada chatbot dibanding manusia ketika terjadi kesalahan. Kesalahan yang dilakukan AI pun bermacam-macam, contohnya adalah informasi yang salah namun terasa meyakinkan. Ketika manusia telah bergantung dan menyadari akan data yang didapatnya dari AI adalah sebuah halusinasi dari AI, maka rasa frustasi pun dapat muncul.

Prinsip Human-Centered AI sebagai Solusi

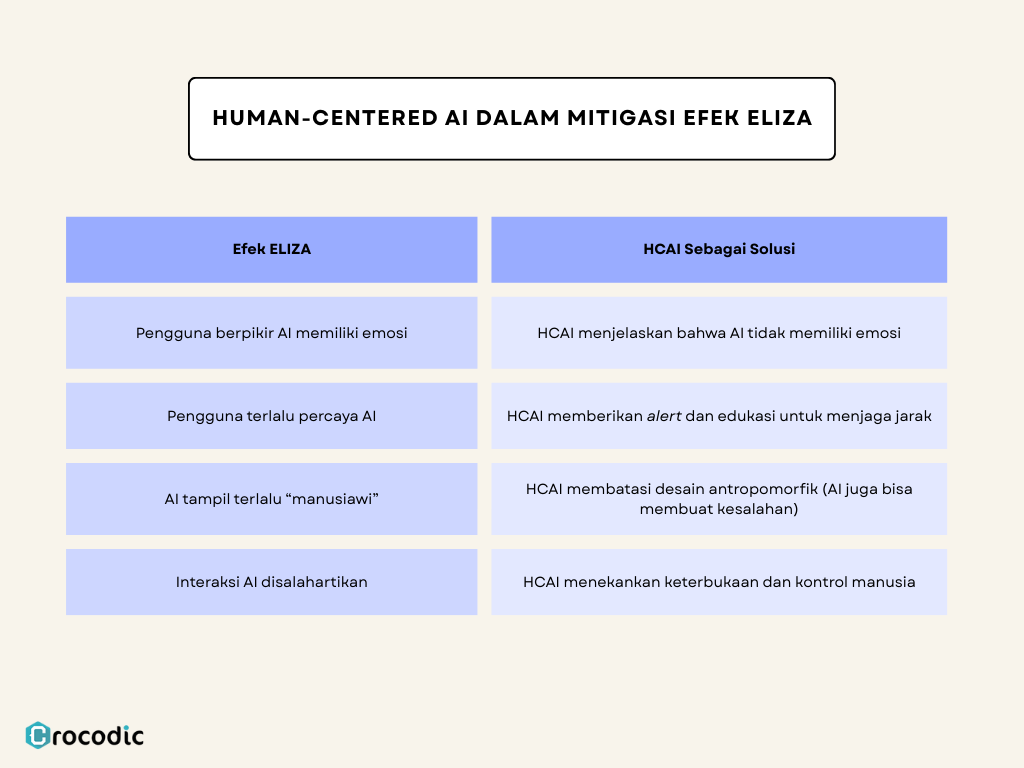

Pihak yang terlibat dalam pengembangan AI bisa berbeda-beda, namun kolaborasi banyak pihak sangat mungkin terjadi. Proses yang melibatkan berbagai pihak ini cocok dan akan menghasilkan AI yang efektif dan sekaligus dapat menghindarkan penggunanya dari efek ELIZA adalah pendekatan Human-Centered AI (HCAI). HCAI didasarkan pada kolaborasi manusia dan AI dengan memastikan hasil yang diberikan bersifat transparan dan sesuai dengan kondisi nyata. Spesialis Human-Centered Design (HCD), pengembang AI, stakeholder lekat dalam konsep HCAI (Chen et al., 2023).

Secara umum, HCAI adalah pendekatan pengembangan AI yang berorientasi pada kebutuhan manusia, menekankan transparansi, kontrol manusia, etika, dan nilai sosial, serta bertujuan untuk menghindari kesalahpahaman dan penyalahgunaan teknologi. Berikut adalah konsep dari HCAI.

- Prinsip Etika dan Nilai Manusia

Human-Centered AI menekankan penerapan prinsip etis, empati, dan orientasi kebutuhan manusia dalam desain teknologi (Chow dan Li, 2024). Artinya, sistem AI harus dibangun agar sejalan dengan nilai-nilai pengguna, misalnya menghormati privasi, menghindari bias, dan tidak menyesatkan. Pendekatan ini memastikan AI berfungsi untuk kesejahteraan manusia, bukan sebaliknya. - Keterlibatan Pemangku Kepentingan (User-Centric)

Mengembangkan AI secara partisipatif membantu mengidentifikasi kesalahan desain sejak dini. Chow dan Li (2024) menyarankan melibatkan beragam pemangku kepentingan (termasuk pengguna dari latar belakang berbeda) untuk mengenali bias atau miskomunikasi sepanjang siklus hidup AI (Chen et al., 2023). Dengan demikian, gangguan psikologis akibat efek ELIZA dapat diminimalisir lewat perbaikan dan edukasi berkelanjutan. - Transparansi dan Keterjelasan (Explainability)

Sistem AI sebaiknya menjelaskan batasannya dengan jelas. Misalnya, selalu menginformasikan pengguna bahwa mereka berinteraksi dengan program otomatis, bukan manusia. McGuire et al. (2023) dalam artikelnya menekankan dilema perusahaan: keuntungan ekonomis dari chatbot harus diseimbangkan dengan kejujuran kepada pelanggan bahwa pesan yang diterimanya berasal dari chatbot. Menegakkan transparansi menghindarkan kepercayaan pada perusahaan pengguna chatbot hancur saat kebohongan terungkap. - Kontrol dan Pengawasan Manusia (Human Oversight)

Sebagai bagian dari prinsip HCAI, manusia harus tetap “mengendalikan” AI. Dalam praktiknya, keputusan kritis harus melalui persetujuan atau pemeriksaan manusia, bukan hanya AI. AI tidak boleh diberikan status sebagai entitas bermoral. Ia hanya “alat” yang pengembangnya bertanggung jawab atas perilakunya (Casalone et al., 2021). - Edukasi dan Literasi tentang AI

Literasi mandiri saja tidak cukup, perlu adanya upaya untuk meningkatkan pemahaman pengguna tentang cara kerja AI agar pengguna tidak mudah terkecoh. Pengguna yang sadar akan keterbatasan AI lebih mungkin menjaga jarak emosional. Selain itu, pelatihan etika bagi pengembang AI (misalnya memasukkan pelatihan nilai dalam kegiatan pengembangan SDM) dapat membantu membangun kesadaran kritis pada tahap desain (Casalone et al., 2021).

Peran Pengembang dan Perusahaan Teknologi

- Penerapan Kode Etik AI

Pengembang AI harus menerapkan prinsip-prinsip seperti keadilan, akuntabilitas, dan perlindungan data pribadi dalam desain. Misalnya, Crocodic dapat mengikuti pedoman internasional (seperti IEEE Ethically Aligned Design atau EU AI Ethics Guidelines) untuk memastikan produk AI-nya tidak melebih-lebihkan kemampuan sistem. - Desain Antarmuka yang Jelas

Pengembang harus merancang dialog dan UI agar tidak “menipu pengguna”. Chatbot yang terlalu “manusiawi” (misalnya berwajah atau bersuara manusia) harus disertai label eksplisit bahwa itu hanyalah sebuah program. Dengan begitu, pengguna tidak merasa “dibodohi” untuk menganggap AI memiliki empati asli. Sebagai contoh nyata, ChatGPT yang telah memberikan teks informasi “ChatGPT can make mistakes.” pada halaman pengguna. - Pengujian dengan Pengguna Asli yang Nyata

Sebelum diluncurkan, AI harus diuji bersama kelompok pengguna yang mewakili audiens target. Proses user testing ini membantu mendeteksi di mana pengguna salah paham (misalnya, terlalu percaya pada kecerdasan AI) dan memperbaiki desain agar lebih jujur dan informatif. Chow dan Li (2024) menekankan pentingnya umpan balik stakeholder dalam mendeteksi bias dan kesalahan desain sejak dini. - Menjaga Kepercayaan Stakeholder

Perusahaan perlu memelihara kepercayaan baik dari pelanggan maupun karyawannya. McGuire et al. (2023) mengamati bahwa pekerja bisa enggan menjalankan kebijakan perusahaan yang menipu pelanggan tentang penggunaan chatbot. Di sisi lain, pelanggan yang mendapatkan pengalaman negatif karena merasa dibohongi mungkin saja dapat menyebarkan reputasi negatif. Untuk itu, transparansi menjadi kunci. Kombinasi kebijakan internal (pelatihan etika, review kode) dan komunikasi yang jujur kepada klien dapat mencegah hilangnya kepercayaan jangka panjang.

Kesimpulan

Efek ELIZA mengingatkan kita bahwa teknologi AI boleh makin pintar, tapi secara fundamental ia tak memiliki kesadaran atau emosi. Kecenderungan manusia memproyeksikan sifat manusiawi pada mesin dapat menyesatkan jika kita tidak waspada. Ahli menekankan bahwa antropomorfisme AI pada dasarnya adalah bagian dari “hype” yang berisiko melebih-lebihkan kemampuan sistem. Oleh karena itu, merancang AI secara etis dan bertanggung jawab menjadi keharusan. Crocodic sendiri memposisikan bahwa pendekatan Human-Centered AI yang menempatkan nilai, transparansi, dan kebutuhan manusia di garis depan dapat menjadi solusi efektif. Dengan demikian, kita menjaga agar AI tetap menjadi alat bantu, bukan sosok pengganti manusia dalam hubungan emosional kita. Semakin banyak perusahaan menerapkan desain yang jujur dan menghormati aspek kemanusiaan, semakin besar pula kepercayaan masyarakat terhadap teknologi AI masa depan. Bagi organisasi yang ingin membangun teknologi berkelanjutan dan beretika, inilah saatnya memulai langkah nyata bersama Crocodic menuju AI yang benar-benar berpihak pada manusia.

Sumber

Alabed, Amani & Javornik, Ana & Gregory-Smith, Diana. (2022). AI anthropomorphism and its effect on users’ self-congruence and self–AI integration: A theoretical framework and research agenda. Technological Forecasting and Social Change. 182. 121786. 10.1016/j.techfore.2022.121786.

Agassi, Joseph & Weizenbaum, Joseph. (1976). Computer Power and Human Reason: From Judgment to Calculation. Technology and Culture. 17. 813. 10.2307/3103715.

Associated Press. (2023, September 28). Family sues chatbot maker after teen’s suicide. AP News. https://apnews.com/article/chatbot-ai-lawsuit-suicide-teen-artificial-intelligence-9d48adc572100822fdbc3c90d1456bd0

Auernhammer, J. (2022). Human-centered AI: The role of Human-centered Design Research in the development of AI. https://doi.org/10.21606/drs.2020.282

Casalone, C., Floridi, L., Palazzani, L., Pegoraro, R., Rossi, F., & Villa, R. (2021). Human-centric AI: From principles to actionable and shared policies. https://www.global-solutions-initiative.org/wp-content/uploads/2025/03/TF4-HUMAN-CENTRIC_AI-_FROM_PRINCIPLES_TO_ACTIONABLE_AND_SHARED_POLICIES.pdf

Chen Y, Clayton E, Novak L, Anders S, Malin B. (2023). Human-Centered Design to Address Biases in Artificial Intelligence. J Med Internet Res 2023;25:e43251

Chow JCL, Li K.(2024). Ethical Considerations in Human-Centered AI: Advancing Oncology Chatbots Through Large Language Models. JMIR Bioinform Biotechnol. doi: 10.2196/64406. PMID: 39321336; PMCID: PMC11579624.

Maples, B., Cerit, M., Vishwanath, A., & Pea, R. (2024). Loneliness and suicide mitigation for students using GPT3-enabled chatbots. npj Mental Health Research, 3, Article 4. https://doi.org/10.1038/s44184-023-00047-6

McGuire, J., De Cremer, D., Hesselbarth, Y. et al. (2023). The reputational and ethical consequences of deceptive chatbot use. Sci Rep 13, 16246. https://doi.org/10.1038/s41598-023-41692-3

Placani, A. Anthropomorphism in AI: hype and fallacy. AI Ethics 4, 691–698 (2024). https://doi.org/10.1007/s43681-024-00419-4

Tang PM, Koopman J, Mai KM, De Cremer D, Zhang JH, Reynders P, Ng CTS, Chen IH. No person is an island: Unpacking the work and after-work consequences of interacting with artificial intelligence. J Appl Psychol. 2023 Nov;108(11):1766-1789. doi: 10.1037/apl0001103. Epub 2023 Jun 12. PMID: 37307359.

Weizenbaum, J. (1966). ELIZA—A computer program for the study of natural language communication between man and machine. Communications of the ACM, 9(1), 36–45. https://doi.org/10.1145/365153.365168