Gambar oleh vectorjuice dari Freepik

- Evolusi dari Alat Menuju Agen yang Otonom

- Bagaimana AI Membuat Keputusan dan Menghasilkan Karya?

- Potensi Kesalahan yang Mungkin Dibuat AI

- AI Sebagai Subjek Hukum, Apakah Mungkin?

- Tanggung Jawab atas Keputusan AI yang Salah

- Regulasi dan Etika Berdasarkan AIA 2024

- Praktikal yang Diperhatikan Negara Lain

- Regulasi di Indonesia

- Solusi untuk Mengurangi Risiko Keputusan AI yang Salah

- Kesimpulan

- Sumber

Evolusi dari Alat Menuju Agen yang Otonom

Artificial Intelligence (AI) atau kecerdasan buatan telah digunakan dalam banyak aspek kehidupan sebagai sebuah alat bantu. Namun, kini AI tidak hanya berperan sebagai alat pasif melainkan telah berevolusi menjadi sistem yang mampu mengambil keputusan kompleks. Dengan berkembangnya konsep AI agents – sistem yang mampu berinisiatif, memiliki otonom dan otomasi – muncul pertanyaan mendasar, sejauh mana AI bisa dipercaya untuk membuat keputusan penting?

Dalam konteks Indonesia, adopsi AI mulai meningkat di berbagai sektor sebagai teknologi bantu (supporting tech). Salah satu contohnya adalah Crocodic, yang telah menerapkan teknologi face recognition dalam aplikasi HR milik Reprime. Sistem tersebut memungkinkan pencatatan kehadiran karyawan secara otomatis dan akurat, mengurangi potensi manipulasi, serta meningkatkan efisiensi operasional. Hal ini merupakan sebuah ilustrasi nyata bagaimana AI mulai diberdayakan untuk mengambil alih proses operasional yang sebelumnya dikerjakan manual. Dengan semakin meluasnya infrastruktur digital dan kebutuhan efisiensi, potensi pemanfaatan AI agents menjadi semakin besar. Namun, belum semua pelaku industri memahami konsekuensinya. Terutama saat adopsinya diterapkan untuk pengambilan keputusan yang berdampak besar pada organisasi atau individu.

Menurut Rusell dan Norvig (2021), AI agents bisa merumuskan tindakan secara independen berdasarkan persepsi dan tujuannya. Namun, bagaimana jika tindakan ini berakibat fatal? Jika AI membuat keputusan yang berdampak besar seperti rekomendasi tindakan medis, pertimbangan kredit, atau menghasilkan karya seni yang mirip ciptaan manusia, maka siapa yang harus bertanggung jawab dan bagaimana posisinya di dalam hukum?

Bagaimana AI Membuat Keputusan dan Menghasilkan Karya?

Dalam sistem AI yang kompleks, pengambilan keputusan dilakukan melalui serangkaian proses seperti machine learning, deep learning, atau reinforcement learning. Pada dasarnya, AI tidak “memikirkan” seperti yang dilakukan manusia, melainkan mengeksekusi keputusan berdasarkan pola dan data yang telah dilatih sebelumnya. Ini berarti, hasil dari suatu proses AI sangat tergantung pada data input, algoritma, serta parameter pelatihan yang digunakan.

Keputusan yang diambil oleh AI agents juga sangat bergantung pada tingkat autonomi dan model pembelajarannya. Semakin tinggi tingkat otonominya, semakin kecil intervensi manusia. AI agents dimungkinkan dapat menyesuaikan diri terhadap konteks yang baru, mengembangkan strategi, dan memberikan respons dengan cara yang tidak selalu bisa diprediksi pengembangnya. Contohnya adalah AI yang digunakan dalam sistem trading otomatis atau manajemen supply chain yang adaptif. Kemudian jika dalam lingkup bisnis, contohnya AI dapat menentukan strategi untuk promosi, menetapkan harga dinamis, atau bahkan merekomendasikan investasi.

AI agents memang dapat membuat keputusan, namun Bryson dan Theodorou (2019) menegaskan bahwa sebagian besar AI saat ini adalah sistem probabilistik, bukan deterministik. Karenanya, keputusan yang diambil selalu mengandung unsur ketidakpastian. Sehingga ada kemungkinan bahwa keputusan yang dibuatnya adalah tidak tepat.

Selain keputusan, AI kini juga dapat menghasilkan karya baik tulisan, gambar, maupun musik. Tools seperti Midjourney atau DALL·E mampu menciptakan gambar dengan berbagai gaya artistik, yang kadang sangat mirip dengan karya manusia. Karya tersebut dapat dihasilkan secara instan melalui prompt. Hasil karya yang digenerasi oleh AI didapatkan melalui pengembangan otomatis berdasar hasil pembelajaran mesin yang sudah diterapkan oleh pengembang.

Namun, menurut Floridi dan Chiriatti (2020), AI tidak menciptakan sesuatu secara “intensional”. Ini berarti karya tersebut bukan hasil dari kesadaran atau niat, melainkan dari korelasi statistik data pelatihan. Hal ini menyulitkan kita untuk dapat membedakan antara hasil dari pencipta asli dan hasil dari pengguna AI, sehingga menimbulkan isu baru seputar orisinalitas, plagiarisme, dan hak cipta dalam dunia kreatif.

Potensi Kesalahan yang Mungkin Dibuat AI

Dari yang sudah kita ketahui dari bagaimana AI dapat membuat keputusan, AI tetap memiliki kemungkinan dalam memberikan keputusan yang tidak tepat dan keliru dalam menghasilkan informasi. Potensinya adalah sebagai berikut.

- Prediksi yang meleset

Prediksi didapatkan dari pembelajaran dari pola yang terbentuk sebelumnya. Namun model pembelajaran mesin sering kali bias apabila training data yang digunakan tidak benar-benar mencerminkan populasi yang sebenarnya (Mehrabi et al., 2021). Misalnya, AI prediktif yang dilatih dari data pelanggan lama dapat memberikan keputusan yang memiliki ketimpangan jika data tersebut tidak merepresentasikan populasi baru. Dalam konteks bisnis, kesalahan prediksi ini bisa berarti kehilangan pelanggan, atau bahkan kerugian finansial.

- Kegagalan dalam deteksi pola baru

AI yang terlalu spesifik akan kesulitan mengenali anomali atau kondisi baru yang belum pernah dipelajari (Amodei et al., 2019). Hal itu juga disebabkan karena kurangnya pemahaman konteks karena data yang dipelajari AI cukup terbatas, sehingga terkadang ada variabel lain yang tidak dipertimbangkan. Contohnya AI yang mengatur pengiriman barang bisa menurunkan biaya tapi mengabaikan kualitas layanan karena parameter yang salah.

- AI Hallucination

Large Language Models (LLMs) kadang menghasilkan informasi yang tampak benar namun ternyata hanya fiktif (Ji et al., 2023). Informasi yang dihasilkan adalah hasil karangan oleh AI yang mana tidak dapat dibuktikan dan tidak mengacu pada referensi tertentu, sehingga disebut “halusinasi”. Ini akan sangat berbahaya, terutama bila digunakan untuk bidang kedokteran, hukum, atau finansial.

- Plagiarisme

Menurut McCormack et al. (2019), AI generatif dapat “meniru” style seniman tanpa izin atau atribusi, sehingga dapat memicu konflik hak cipta. Fenomena baru-baru ini seperti AI (ChatGPT) yang menghasilkan ilustrasi dengan art style milik Studio Ghibli telah menjadi kontroversi di komunitas kreatif di Indonesia. Ini menunjukkan bagaimana AI dapat melewati batasnya meski secara teknis tidak sadar akan tindakannya. Walau demikian, tidak semua prompt diterima oleh ChatGPT, karena pada dasarnya ChatGPT tetap diberi batasan oleh pengembang. Kasus ini dapat dijadikan contoh pentingnya regulasi dan etika dalam AI.

AI Sebagai Subjek Hukum, Apakah Mungkin?

Dalam sistem hukum Indonesia, hanya manusia dan badan hukum seperti perusahaan yang dapat menjadi subjek hukum. Konstruksi ini didasarkan pada Kitab Undang-Undang Hukum Perdata (KUHPerdata) dan Undang-Undang Informasi dan Transaksi Elektronik (UU ITE), yang memposisikan teknologi seperti AI sebagai objek hukum, bukan subjek. Artinya, AI hanya dapat digunakan dan dimanfaatkan oleh manusia atau badan hukum, namun tidak dapat dikenai tanggung jawab hukum secara langsung.

Penelitian oleh Haris (2023) menyoroti bahwa AI dalam kerangka hukum Indonesia diposisikan sebagai agen elektronik, terutama dalam konteks transaksi elektronik. Meskipun AI dapat menjalankan peran agen untuk melakukan tindakan hukum atas nama manusia atau badan hukum, namun entitas ini tidak memiliki kehendak (will) atau pertanggungjawaban moral (moral accountability). Oleh karena itu, AI sebagai agen elektronik hanya menjalankan instruksi yang telah diprogram, dan setiap tindakan hukum yang dilakukan tetap melekat pada pengguna atau pemilik sistem.

Hal ini sejalan dengan pandangan Leenes dan Lucivero (2014), yang menekankan bahwa pengakuan AI sebagai entitas hukum yang mandiri memerlukan reformasi hukum besar-besaran. Dalam perdebatan hukum di Uni Eropa, sempat muncul wacana untuk mengklasifikasikan AI sebagai “electronic personhood”. Namun proposal ini ditolak karena dikhawatirkan dapat melepaskan tanggung jawab hukum dari pihak manusia atau badan hukum yang menciptakan, mengoperasikan, atau mengambil manfaat dari sistem AI tersebut.

Di Indonesia sendiri, belum ada upaya konkret untuk membentuk kerangka hukum baru yang memungkinkan AI menjadi subjek hukum. Kementerian Komunikasi dan Informatika (Kominfo) hanya menetapkan prinsip kehati-hatian (precautionary principle) bagi pengguna teknologi AI, sebagaimana termuat dalam pedoman etik penggunaan AI di Indonesia yang diterbitkan pada tahun 2023. Ini mencerminkan kehati-hatian pemerintah dalam menyikapi perkembangan teknologi, sambil tetap menjaga prinsip akuntabilitas hukum pada manusia.

Dengan demikian, meskipun AI semakin canggih dan otonom dalam menjalankan fungsi-fungsinya, dalam sistem hukum Indonesia saat ini, AI tetap dipandang sebagai alat atau agen elektronik semata, bukan entitas yang dapat dimintai pertanggungjawaban hukum secara mandiri.

Tanggung Jawab atas Keputusan AI yang Salah

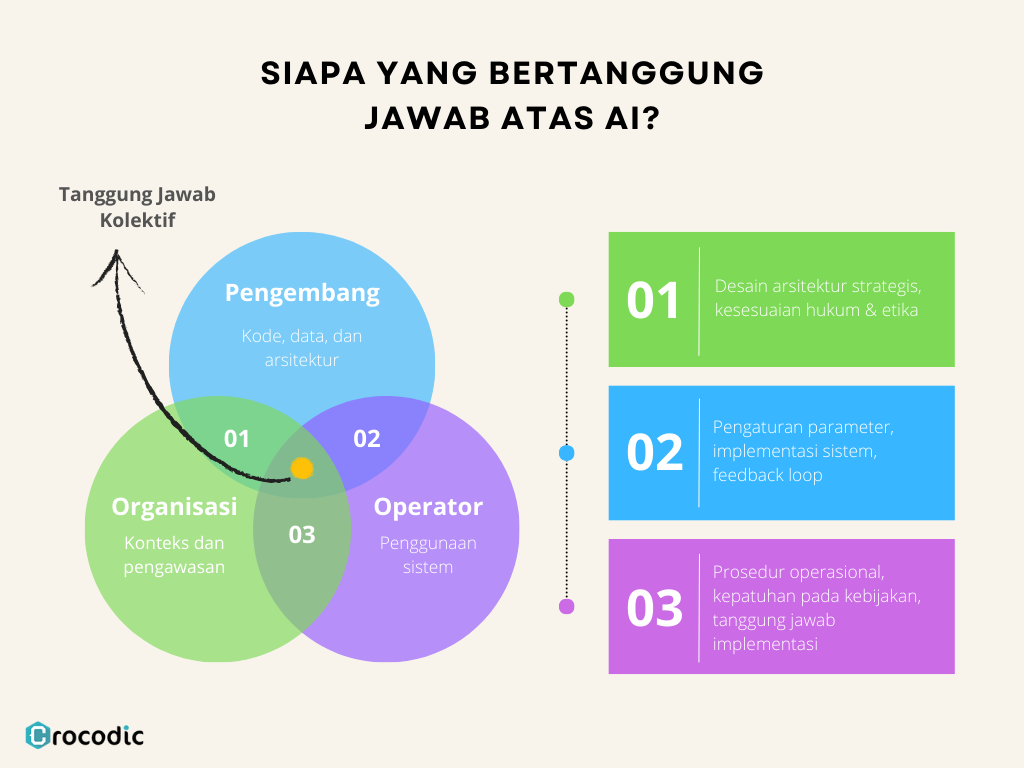

Siapa yang bertanggung jawab saat AI mengambil keputusan yang merugikan? Berdasarkan karya tulis dari Gless et al. (2016), Pagallo (2013), dan Bryson & Theodorou (2019), tanggung jawab atas keputusan AI tidak hanya dimiliki satu pihak, tetapi merupakan hasil kolaborasi antara pihak – pihak berikut.

- Pengembang: Bertanggung jawab atas desain dan kode AI.

- Operator atau pengguna: Bertanggung jawab atas penggunaan sistem dalam konteks tertentu.

- Organisasi: Jika AI digunakan dalam lingkungan kerja, maka organisasi bisa dimintai pertanggungjawaban secara hukum.

Dalam kerangka strict liability, bahkan jika tidak ada niat jahat, kerugian tetap dapat dituntut pada pihak pemilik sistem (Pagallo, 2013).

Visualisasi dari tanggung jawab pihak terkait dapat diilustrasikan seperti gambar di atas. Yang mana di antara ketiganya, juga terdapat hubungan untuk setiap masing-masing pihak.

- Pengembang & Organisasi: Pengembang bertugas membangun sistem AI sesuai kebutuhan organisasi, termasuk mempertimbangkan prinsip etika, peraturan, dan standar industri. Organisasi harus memastikan pengembang mengikuti prinsip governance yang sesuai.

- Pengembang & Operator: Pengembang dan pengguna saling bekerja sama dalam konfigurasi dan penerapan sistem AI. Pengguna memberikan feedback terhadap sistem yang digunakan, dan pengembang melakukan penyesuaian berdasarkan penggunaan aktual. Misalnya: tuning algoritma berdasarkan feedback penggunaan di lapangan.

- Operator & Organisasi: Pengguna beroperasi di bawah struktur dan aturan organisasi. Mereka bertanggung jawab memastikan sistem AI digunakan sesuai kebijakan organisasi, serta menjalankan standar operasional yang telah ditetapkan.

Regulasi dan Etika Berdasarkan AIA 2024

Artificial Intelligence Act (AIA) 2024 yang disahkan oleh Uni Eropa merupakan langkah besar dalam upaya global untuk mengatur AI. AIA mengklasifikasikan sistem AI ke dalam empat tingkat risiko: minimal, terbatas, tinggi, dan dilarang. AI agents yang mengambil keputusan strategis atau mempengaruhi hak fundamental manusia termasuk dalam kategori berisiko tinggi.

Regulasi ini mengharuskan pengembang dan pengguna AI melakukan evaluasi dampak, menyediakan dokumentasi lengkap, serta menjamin transparansi dan akuntabilitas. Salah satu poin penting adalah “human oversight”, yaitu kemampuan manusia untuk menghentikan atau mengubah keputusan AI bila diperlukan.

AIA menjadi contoh konkret bagaimana regulasi tidak harus menghambat inovasi, tetapi justru menyeimbangkan antara manfaat dan risiko teknologi. Ini bisa menjadi acuan penting bagi negara seperti Indonesia yang sedang merumuskan regulasi sejenis.

Praktikal yang Diperhatikan Negara Lain

Kasus penggunaan AI dalam sistem hukum dan pelayanan publik di negara-negara maju menunjukkan bahwa meskipun teknologi ini mampu memberikan efisiensi, ia juga memiliki potensi memperkuat bias sistemik jika tidak diawasi dengan ketat.

Di Amerika Serikat, sistem algoritmik bernama COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) digunakan untuk memprediksi risiko residivisme – kemungkinan seorang terdakwa mengulangi tindak kejahatan. Namun, investigasi yang dilakukan oleh ProPublica (Angwin et al., 2016) mengungkap bahwa COMPAS cenderung memberikan skor risiko tinggi terhadap terdakwa berkulit hitam, meskipun mereka memiliki rekam jejak kriminal yang ringan atau tidak ada sama sekali. Sebaliknya, terdakwa kulit putih dengan catatan kriminal lebih berat justru diberi skor risiko rendah. Meski algoritma ini secara teknis hanya memberikan rekomendasi, kenyataannya banyak hakim yang menjadikannya sebagai acuan utama dalam keputusan pemberian hukuman atau pembebasan bersyarat. Ini menimbulkan pertanyaan mendasar: sejauh mana keputusan “dibantu AI” tetap bisa dianggap sebagai keputusan manusia?

Sementara itu, di Inggris, AI telah diterapkan dalam berbagai sistem pelayanan publik dan proses seleksi kerja. Salah satu kasus menonjol adalah penghentian sistem prediksi imigrasi yang digunakan oleh Home Office Inggris, setelah ditemukan bahwa algoritmanya secara sistematis mendiskriminasi warga dari negara-negara tertentu (BBC, 2020). Selain itu, beberapa sistem rekrutmen otomatis di sektor swasta juga dituding tidak transparan dan berpotensi merugikan pelamar dari latar belakang tertentu. Hal ini memicu gelombang gugatan dan kritik dari kelompok advokasi hak asasi manusia.

Menanggapi hal tersebut, pemerintah Inggris mulai menyusun kerangka etika serta prosedur audit mandiri bagi sistem AI yang digunakan dalam pelayanan publik. Tujuannya adalah memastikan bahwa algoritma yang diterapkan tidak hanya efisien, tetapi juga adil, transparan, dan dapat dipertanggungjawabkan. Kedua kasus ini menekankan pentingnya regulasi yang komprehensif serta keterlibatan publik dalam pengawasan implementasi AI, terutama ketika teknologi ini menyentuh aspek-aspek yang berdampak langsung terhadap kehidupan dan hak-hak individu.

Regulasi di Indonesia

Kominfo telah mengeluarkan Surat Edaran No. 9 Tahun 2023 sebagai dasar prinsip etis penggunaan AI, namun belum bersifat mengikat. Beberapa hukum yang berlaku di antara lain sebagai berikut.

- UU No. 1 Tahun 2024 tentang ITE

- UU No. 27 Tahun 2022 tentang Perlindungan Data Pribadi

- PP No. 71 Tahun 2019 tentang Penyelenggaraan Sistem Elektronik

Dalam konteks hak cipta, UU No. 28 Tahun 2014 masih mengharuskan adanya pencipta manusia. Maka, karya AI tidak dapat dilindungi sebagai hasil orisinal kecuali dalam bentuk joint authorship bersama manusia (WIPO, 2023).

Solusi untuk Mengurangi Risiko Keputusan AI yang Salah

Beberapa langkah mitigasi yang bisa diterapkan:

- Audit sistem AI secara berkala, terutama untuk sistem yang digunakan dalam keputusan penting.

- Penetapan “kill switch” untuk menghentikan operasi AI dalam keadaan darurat.

- Dokumentasi proses pelatihan model, dapat mempermudah investigasi bila terjadi suatu kesalahan.

- Keterlibatan manusia dalam setiap keputusan strategis (human-in-the-loop), agar keputusan tetap bisa diverifikasi oleh manusia.

- Mendorong regulasi nasional yang sejalan dengan praktik internasional – adaptasi dapat berjalan selaras.

Kesimpulan

Meskipun AI agents membawa efisiensi dan otomatisasi yang luar biasa, potensi kesalahan, bias, dan pertanggungjawaban hukum yang belum jelas menuntut adanya regulasi serta praktik etika yang ketat dalam pengembangannya. Di tengah tren global menuju pemanfaatan AI yang lebih otonom, penting bagi perusahaan untuk tidak hanya mengejar kecanggihan teknologi, tetapi juga menjamin keadilan, transparansi, dan keamanan data dalam sistem yang mereka bangun. Di sinilah Crocodic hadir sebagai mitra yang tidak hanya menyediakan solusi digital berbasis AI, tetapi juga memprioritaskan etika dan kepatuhan hukum. Dengan pendekatan berbasis prinsip kehati-hatian dan integrasi “human-in-the-loop“, Crocodic berkomitmen untuk membantu klien menghadirkan inovasi yang cerdas, bertanggung jawab, dan berkelanjutan di era kecerdasan buatan.

Sumber

http://tandfonline.com/doi/full/10.1080/13600834.2023.2196827#d1e96

Amodei, D., Olah, C., Steinhardt, J., Christiano, P., Schulman, J., & Mané, D. (2016). Concrete Problems in AI Safety.

Angwin, J., Larson, J., Mattu, S., & Kirchner, L. (2016). Machine bias. ProPublica.

Bryson, J. J., & Theodorou, A. (2019). How society can maintain human-centric artificial intelligence. IEEE Computer, 52(6), 56-63.

European Commission. (2024). Artificial Intelligence Act.

Floridi, L., & Chiriatti, M. (2020). GPT-3: Its nature, scope, limits, and consequences. Minds and Machines, 30(4), 681–694.

Gless, S., Silverman, E., & Weigend, T. (2016). If robots cause harm, who is to blame? New Criminal Law Review, 19(3), 412–436.

Haris, M. T. A. R (2023). Kajian Konstruksi Hukum AI Sebagai Agen Elektronik dalam Transaksi. Jurnal Ilmu Administrasi Negara, 23(3), 307–316.

Ji, Z., Lee, N., Frieske, R., Yu, T., Su, D., Xu, Y., … & Wang, H. (2023). Survey of hallucination in natural language generation. ACM Computing Surveys (CSUR), 55(12), 1-38.

Kominfo. (2023). Surat Edaran Menteri Kominfo No. 9 Tahun 2023 tentang Etika Pengembangan AI.

Leenes, R., & Lucivero, F. (2014). Laws on robots, laws by robots, laws in robots: Regulating robot behaviour by design. Law, Innovation and Technology, 6(2), 193–220.

McCormack, J., Gifford, T., & Hutchings, P. (2019). Autonomy, authenticity, authorship and intention in computer generated art. Computational Creativity, 1–8.

Mehrabi, N., Morstatter, F., Saxena, N., Lerman, K., & Galstyan, A. (2021). A survey on bias and fairness in machine learning. ACM Computing Surveys (CSUR), 54(6), 1–35.

Pagallo, U. (2013). The Laws of Robots: Crimes, Contracts, and Torts. Springer.

WIPO. (2023). AI and Intellectual Property Policy. World Intellectual Property Organization.